生成AI利用における主な3つのセキュリティリスク

生成AIは便利な一方で、セキュリティ面の理解や設定を誤るとリスクがあります。

本記事では代表的な3つのリスクと、初心者でもわかりやすいリスク対策を解説します。

1.入力内容の「情報漏洩」リスク

AIに入力した情報が学習データとして扱われたり、将来的に他のユーザーへの回答に反映されるリスクがあります。たとえば、社内資料・経営戦略・顧客情報などをそのまま入力するのは非常に危険です。

対策ポイント:

- 機密情報は入力しない

- 必ずオプトアウト設定(入力内容の学習利用を止める)を確認する

2.「誤情報(ハルシネーション)」の出力リスク

生成AIは、事実と異なる情報を“もっともらしく”答えることがあります。これは「ハルシネーション」と呼ばれ、誤った判断や情報拡散につながる危険があります。

対策ポイント:

- 出力結果は必ず複数の信頼できる情報源で検証(「根拠も示して」とAIに促す)

- 重要情報は出典リンクを必ず確認

- AIを「調査の補助」として使い、最終判断は人間が行う

3.利用履歴やカスタマイズ設定の「管理リスク」

AIサービスは通常、やり取りの履歴やユーザー設定を保存しています。便利な反面、情報管理のルールが曖昧なまま利用すると、意図せぬ漏洩や共有リスクが発生することも。

対策ポイント:

- 共有PCでは必ず「履歴をオフ」に設定

- アカウントごとのアクセス権限を明確化。業務用と個人用のアカウントを分離

- ログイン状態やカスタマイズ内容を定期的に見直す

生成AI情報漏洩対策:オプトアウト設定の手順

生成AIを安全に使うためには、まず オプトアウト設定 で自分のデータがAIモデルの学習に使用されないように制御します。

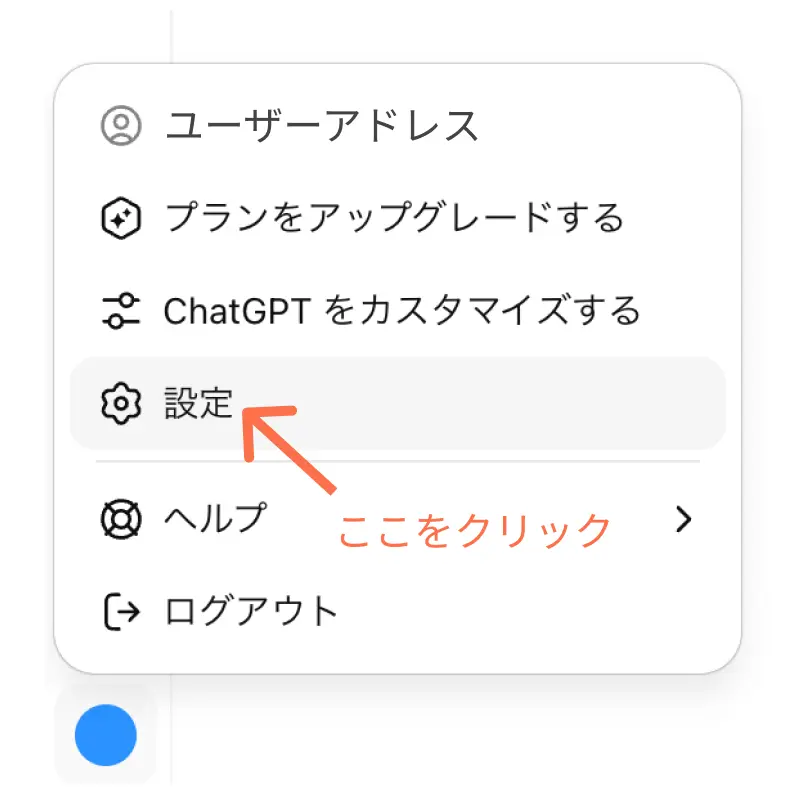

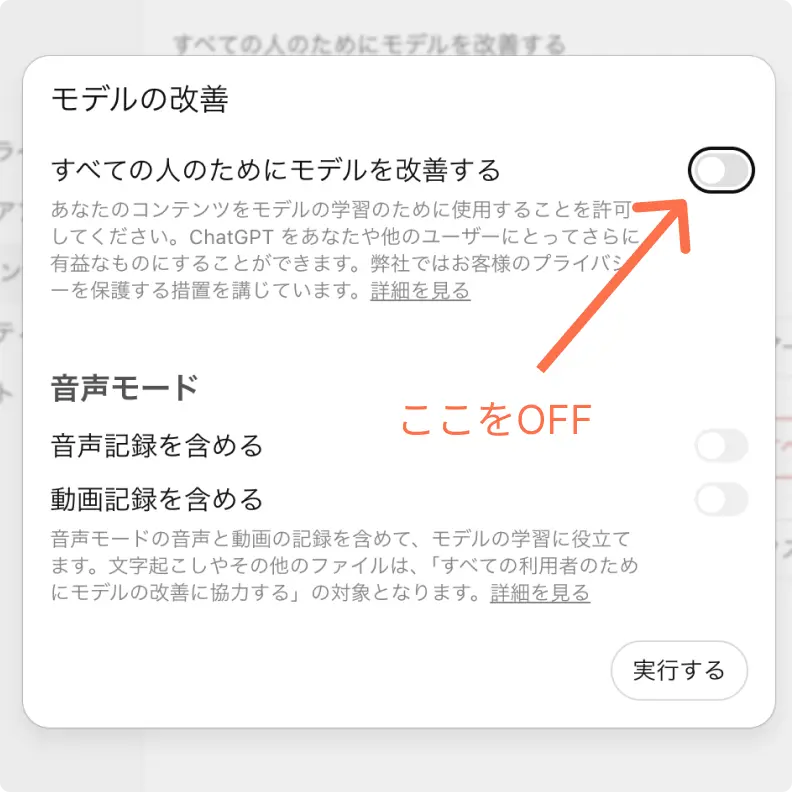

ChatGPTのオプトアウト設定例

ChatGPT画面

- ChatGPTにログイン

- 画面左下のアカウント名(プランによって位置やアイコンが異なる場合があります) → 「設定」を選択

- 「データコントロール」をクリック

- 「すべての人のためにモデルを改善する」のスライドボタンをオフ

Gemini(Google)

- Googleアカウントの「アクティビティ管理」で利用データの保存を制御

Claude(Anthropic)

- 「Constitutional AI」で既に制限強め、ただし履歴管理は確認必須

※他のAIサービスでも「利用履歴の収集を止める」「学習に使用しない」といった設定を確認してください。

将来的な動向:オプトアウトからオプトインへ

現状は「デフォルトで学習に利用される → 使いたくなければオプトアウト」というモデルですが、今後は『明示的に同意しなければ学習に使われない(オプトイン)』モデルへ移行する動きが強まっています。これはユーザー主権を尊重する流れであり、欧州や一部の国ではすでに議論が進行中です。

まとめ:2025年最新版生成AIセキュリティ対策

生成AI安全利用チェックリスト

- 機密情報を入力しない

→ 社内データや個人情報はNG。AIに覚えさせないのが鉄則。 - オプトアウト設定を必ず行う

→ 学習への利用を防ぐ。各サービスの設定画面から確認。 - 出力内容をうのみにしない

→ 誤情報(ハルシネーション)対策に、必ず複数ソースで照合。 - 根拠や出典をAIに求める

→ 「その情報の元は?」と聞くだけで精度アップ。 - 履歴をオフ/定期的に削除する

→ 特に共有PCや業務環境では必須。 - 業務用と個人用アカウントを分ける

→ 意図せぬ共有や誤用を防止。 - 有料プランや業務利用の場合は二段階認証を有効化

→ アカウント乗っ取りのリスク回避。

これらを押さえることで、生成AIを安全に、かつ効果的に活用することができます。

「おっと!ここまで読んで“まだセキュリティ不安だわ〜”って人は、さらに一歩先へGO!

実はChatGPTの有料プラン(Plus)なら、より強固な管理設定が可能だし、究極を目指すなら今はローカル環境で動かすAI(オフラインAI)って選択肢もあるよ。

あなたにピッタリのAI探してみる?

Chat GPT白猫